1月3日消息,據(jù)《Popular Science》今日?qǐng)?bào)道,近年來(lái),一部分雙足機(jī)器人在動(dòng)作靈活性和人類化表現(xiàn)上取得了顯著進(jìn)步。然而,它們的面部表情依然顯得僵硬,無(wú)法以接近人類的速度和復(fù)雜度模擬面部肌肉的動(dòng)態(tài)...

IT之家 1 月 3 日消息,據(jù)《Popular Science》今日?qǐng)?bào)道,近年來(lái),一部分雙足機(jī)器人在動(dòng)作靈活性和人類化表現(xiàn)上取得了顯著進(jìn)步。然而,它們的面部表情依然顯得僵硬,無(wú)法以接近人類的速度和復(fù)雜度模擬面部肌肉的動(dòng)態(tài)變化。

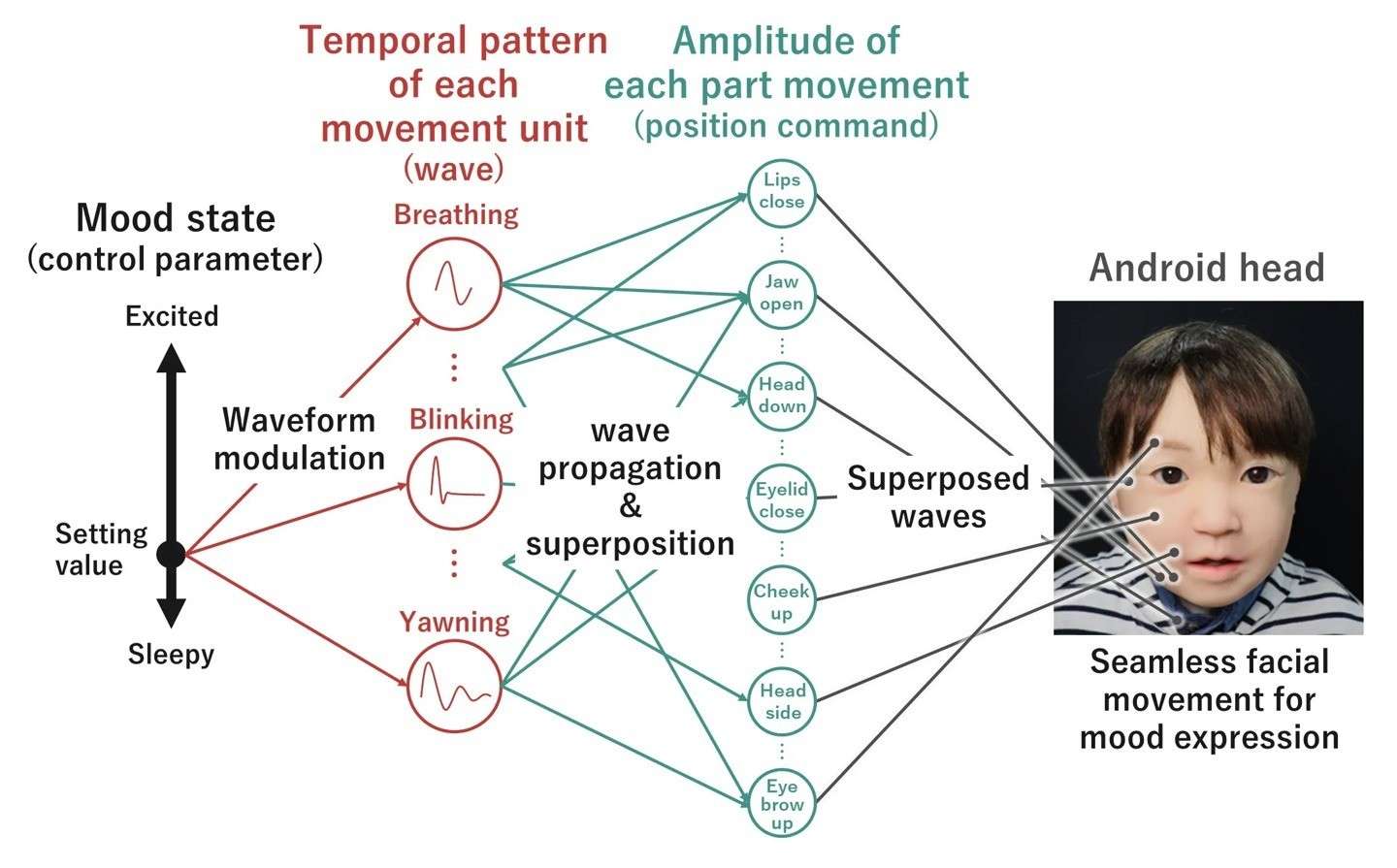

不過(guò),日本大阪大學(xué)的研究人員提出了一種新的“動(dòng)態(tài)喚醒表情”系統(tǒng),有望為這一問(wèn)題提供解決方案,使機(jī)器人能夠更快、更自然地再現(xiàn)面部表情。

研究人員將打哈欠、眨眼和呼吸等面部動(dòng)作歸類為不同的波形信號(hào),并與嘴唇開(kāi)合、眉毛移動(dòng)和頭部?jī)A斜等動(dòng)作幅度掛鉤。在實(shí)驗(yàn)中,研究人員根據(jù)“困倦”到“興奮”的情緒光譜設(shè)置控制參數(shù)。這些波形通過(guò)傳播和疊加動(dòng)態(tài)調(diào)整機(jī)器人的面部特征表現(xiàn),從而避免了過(guò)去為每種表情手動(dòng)編排動(dòng)作的復(fù)雜過(guò)程。

研究團(tuán)隊(duì)在論文中指出:“自動(dòng)生成動(dòng)態(tài)面部表情以傳達(dá)機(jī)器人的情緒狀態(tài),對(duì)于社交型機(jī)器人來(lái)說(shuō)至關(guān)重要。”他們強(qiáng)調(diào),當(dāng)前機(jī)器人表情的生成依賴于拼湊式的預(yù)錄動(dòng)作,這往往難以達(dá)到真實(shí)效果。

以“困倦”情緒為例,該系統(tǒng)會(huì)調(diào)節(jié)機(jī)器人在呼吸、打哈欠和眨眼等參數(shù)上的表現(xiàn)。這些動(dòng)作會(huì)進(jìn)一步疊加,放大或縮小嘴部、眼皮和頭部的變化。最終,經(jīng)過(guò)計(jì)算的表情幾乎可以瞬間呈現(xiàn)。

研究負(fù)責(zé)人大須賀公一( Koichi Osuka )表示:“這項(xiàng)動(dòng)態(tài)表情合成研究的突破,將幫助機(jī)器人實(shí)現(xiàn)更復(fù)雜的面部動(dòng)作,展現(xiàn)更生動(dòng)的表情,并根據(jù)環(huán)境變化和人類互動(dòng)傳達(dá)情緒。”

這項(xiàng)研究已經(jīng)發(fā)表在《機(jī)器人與機(jī)電一體化》上,IT之家附鏈接:點(diǎn)此前往

來(lái)源:本文內(nèi)容搜集或轉(zhuǎn)自各大網(wǎng)絡(luò)平臺(tái),并已注明來(lái)源、出處,如果轉(zhuǎn)載侵犯您的版權(quán)或非授權(quán)發(fā)布,請(qǐng)聯(lián)系小編,我們會(huì)及時(shí)審核處理。

聲明:江蘇教育黃頁(yè)對(duì)文中觀點(diǎn)保持中立,對(duì)所包含內(nèi)容的準(zhǔn)確性、可靠性或者完整性不提供任何明示或暗示的保證,不對(duì)文章觀點(diǎn)負(fù)責(zé),僅作分享之用,文章版權(quán)及插圖屬于原作者。

最熱文章

最熱文章Copyright©2013-2025 ?JSedu114 All Rights Reserved. 江蘇教育信息綜合發(fā)布查詢平臺(tái)保留所有權(quán)利

![]() 蘇公網(wǎng)安備32010402000125

蘇ICP備14051488號(hào)-3技術(shù)支持:南京博盛藍(lán)睿網(wǎng)絡(luò)科技有限公司

蘇公網(wǎng)安備32010402000125

蘇ICP備14051488號(hào)-3技術(shù)支持:南京博盛藍(lán)睿網(wǎng)絡(luò)科技有限公司

南京思必達(dá)教育科技有限公司版權(quán)所有 百度統(tǒng)計(jì)